L’adaptation de rang faible, ou LoRA, représente une avancée significative dans le domaine des modèles de langage à grande échelle (LLM). Cette technique innovante promet de transformer la manière dont nous affinons ces modèles, en réduisant considérablement les coûts et en augmentant l’efficacité. Dans cet article, nous explorerons en profondeur ce qu’est LoRA, comment elle fonctionne, et pourquoi elle est devenue un outil incontournable pour les professionnels de l’apprentissage automatique.

Table des matières

Qu’est-ce que LoRA ?

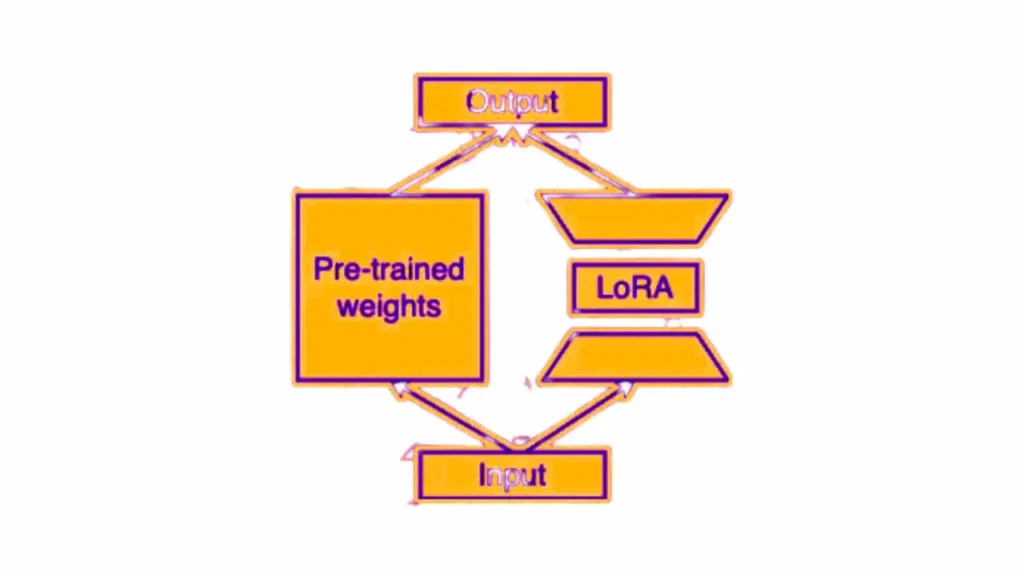

LoRA, ou l’adaptation de rang faible, est une technique révolutionnaire dans le monde des modèles de langage à grande échelle (LLM). Cette méthode se distingue par sa capacité à modifier de manière sélective un sous-ensemble de paramètres au sein d’un modèle pré-entraîné. Ce faisant, LoRA réduit considérablement la complexité et les coûts associés à l’ajustement fin des LLM, tout en préservant leur efficacité et leur précision.

Comment fonctionne l’ajustement fin des LLM ?

L’ajustement fin des modèles de langage, en particulier ceux de grande envergure, est un processus complexe et crucial pour leur efficacité dans des tâches spécifiques.

Processus traditionnel d’ajustement fin

- Révision globale : Dans la méthode conventionnelle, l’ajustement fin implique la modification de l’ensemble des paramètres du modèle. Cela signifie que chaque poids et biais dans le réseau neuronal est recalibré pour s’adapter à une tâche ou un ensemble de données spécifique.

- Coûts et ressources : Cette approche nécessite une puissance de calcul élevée et peut s’avérer onéreuse, surtout pour les modèles de grande taille. La révision globale des paramètres demande également un temps considérable, ce qui peut être un frein dans des contextes où la rapidité est essentielle.

Approche alternative d’ajustement fin

- Ciblage spécifique : En contraste avec la méthode traditionnelle, une approche alternative consiste à cibler un sous-ensemble spécifique de paramètres pour l’ajustement. Cette méthode se concentre sur la modification de certaines parties du modèle plutôt que de l’ensemble, ce qui peut être plus efficace pour des tâches spécifiques.

- Optimisation et efficacité : En se focalisant sur des zones clés du modèle, cette approche permet une optimisation plus rapide et moins coûteuse. Elle est particulièrement utile pour des ajustements fins où seuls certains aspects du modèle doivent être modifiés pour s’adapter à de nouvelles données ou tâches.

La séparation des paramètres pré-entraînés et des paramètres affinés est une partie importante de LoRA.

La technique classique d’ajustement fin des modèles ML

Dans les méthodes traditionnelles, l’ajustement fin des modèles d’apprentissage automatique consiste à ajuster tous les poids du modèle. Bien que cette approche soit globalement efficace, elle est souvent gourmande en ressources et en temps. LoRA, en offrant une alternative plus ciblée, ouvre la voie à des processus plus rapides et moins onéreux.

Avantages de LoRA

LoRA se distingue par plusieurs avantages significatifs, en particulier lorsqu’il s’agit d’optimiser les modèles de langage à grande échelle.

Réduction des coûts et efficacité accrue

- Économie de ressources : L’un des principaux avantages de LoRA est la réduction des coûts. En ne modifiant qu’un sous-ensemble de paramètres, les ressources nécessaires pour l’ajustement fin sont considérablement diminuées.

- Efficacité améliorée : Cette méthode n’impacte pas seulement le coût, mais aussi l’efficacité. Les modèles ajustés via LoRA maintiennent une performance élevée, ce qui est crucial pour les applications pratiques.

Séparation des poids pré-entraînés et ajustés

- Flexibilité et personnalisation : La séparation des poids pré-entraînés et ajustés permet une plus grande flexibilité. Les utilisateurs peuvent personnaliser les modèles pour des tâches spécifiques sans altérer le modèle de base.

- Préservation de l’intégrité du modèle : Cette approche préserve l’intégrité du modèle original tout en permettant des ajustements fins et ciblés, essentiels pour des applications spécifiques.

Améliorations supplémentaires avec LoRA

- Adaptabilité : LoRA offre une adaptabilité remarquable, permettant aux modèles de s’ajuster à diverses tâches sans nécessiter une refonte complète.

- Innovation continue : En tant que technique relativement nouvelle, LoRA continue d’évoluer, promettant des améliorations et des applications encore plus vastes dans le futur.

Lire également :

- ChatGPT en programmation : Comment écrire un meilleur code avec ChatGPT

- Les 10 Meilleurs GPTs Personnalisés : Innovation et Impact dans le Monde de l’IA

- Comment activer ChatGPT Voice to Voice sur le téléphone (iPhone & Android)

- Les Prompts émotionnels améliorent les modèles linguistiques selon une étude

Mise en œuvre de LoRA

L’implémentation de LoRA dans les projets d’apprentissage automatique est un processus qui nécessite une compréhension approfondie de ses principes et de ses applications pratiques.

Guide pratique pour appliquer LoRA

1. Compréhension des principes fondamentaux

- Étude approfondie : Avant de débuter l’implémentation d’une méthode d’ajustement fin ciblé, il est crucial de maîtriser ses principes de base. Cela implique de comprendre comment cette technique modifie de manière sélective certains paramètres des modèles de langage, sans altérer l’ensemble du modèle.

- Importance de la théorie : Une solide compréhension théorique est nécessaire pour appliquer efficacement cette méthode. Cela inclut la connaissance des structures de modèles de langage et de la manière dont les ajustements fins affectent leur performance.

2. Sélection des outils appropriés

- Choix des langages et frameworks : Le choix des outils est un aspect crucial. Python, par exemple, est largement utilisé dans le domaine de l’intelligence artificielle et offre une gamme de bibliothèques qui facilitent l’application de techniques d’ajustement fin ciblé.

- Flexibilité et compatibilité : Il est important de sélectionner des outils qui sont non seulement puissants mais aussi compatibles avec les modèles et les données existants.

3. Utilisation de Python pour l’ajustement fin

- Ressources disponibles : Python offre un éventail de ressources, comme des tutoriels et des exemples de code, qui sont extrêmement utiles pour les développeurs cherchant à appliquer des méthodes d’ajustement fin ciblé.

- Intégration dans les projets existants : L’utilisation de Python permet une intégration fluide dans les projets d’IA existants, offrant ainsi une grande flexibilité et facilité d’utilisation pour les développeurs et chercheurs.

Conclusion

L’adaptation de rang faible, ou LoRA, représente une avancée majeure dans le domaine de l’apprentissage automatique, en particulier pour l’ajustement fin des modèles de langage à grande échelle. Cette technique se distingue par sa capacité à optimiser les modèles de manière efficace et économique, en se concentrant sur un sous-ensemble spécifique de paramètres.

Les avantages de LoRA, tels que la réduction des coûts, la préservation de l’intégrité des modèles pré-entraînés, et la flexibilité dans la personnalisation, en font un outil précieux pour les chercheurs et les développeurs en IA.

Avec l’évolution continue de la technologie et la recherche dans le domaine, LoRA promet de jouer un rôle de plus en plus important dans le futur de l’apprentissage automatique. Sa facilité d’implémentation, notamment grâce à des ressources disponibles en Python, rend cette technique accessible à un large éventail de professionnels. En somme, LoRA n’est pas seulement une innovation technique, mais aussi un catalyseur potentiel pour de nouvelles avancées dans le traitement du langage naturel et au-delà.

FAQ sur LoRA

1. Qu’est-ce qui différencie LoRA des autres techniques d’ajustement fin ?

- Réponse : LoRA se distingue par sa capacité à ajuster un sous-ensemble spécifique de paramètres dans un modèle de langage, contrairement aux méthodes traditionnelles qui nécessitent la modification de l’ensemble des paramètres. Cette approche ciblée réduit les coûts et la complexité tout en préservant l’efficacité du modèle.

2. Peut-on utiliser LoRA pour tous les types de modèles de langage ?

- Réponse : LoRA est principalement conçue pour les modèles de langage à grande échelle. Cependant, ses principes peuvent être adaptés à divers types de modèles d’apprentissage automatique, en fonction de leurs spécificités et de leurs besoins en ajustement fin.

3. Quels sont les principaux avantages de l’utilisation de LoRA ?

- Réponse : Les principaux avantages de l’adaptation de rang faible incluent la réduction significative des coûts et des ressources nécessaires pour l’ajustement fin, la préservation de l’intégrité du modèle de base, et la possibilité de personnaliser les modèles pour des tâches spécifiques sans refonte complète.

4. Est-il difficile d’implémenter LoRA dans un projet existant ?

- Réponse : L’implémentation de l’adaptation de rang faible nécessite une compréhension de ses principes, mais grâce aux ressources disponibles, notamment en Python, son intégration dans des projets existants peut se faire de manière relativement aisée. La clé réside dans la sélection des bons outils et une planification soignée.

5. LoRA est-elle une technique en constante évolution ?

- Réponse : Oui, l’adaptation de rang faible est une technique relativement nouvelle et continue d’évoluer. La recherche en cours dans le domaine de l’apprentissage automatique promet des améliorations et des applications encore plus vastes pour LoRA à l’avenir.

Mandiaye Ndiaye ! Expert en Management d'Activité Opérationnelle | Spécialiste SEO & Transformation Digitale | Web Design & Contenu Optimisé IA |

[…] LoRA : Révolutionner l’ajustement fin des modèles de langage à grande échelle […]

[…] LoRA : Révolutionner l’ajustement fin des modèles de langage à grande échelle […]